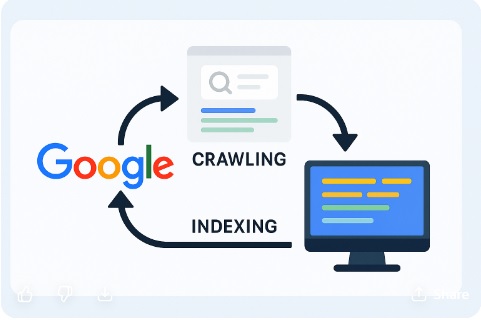

Google je već dugi niz godina najpopularnija tražilica na svijetu i ključni alat za pronalazak informacija na internetu. Iako se mnogima čini da je pretraživanje interneta trenutan proces, iza svakog rezultata stoji složen sustav tehnologija i procesa. Google zapravo ne pretražuje internet u realnom vremenu, nego pristupa svojoj vlastitoj bazi podataka, odnosno indeksu koji je izgradio skeniranjem i analizom web stranica. Taj proces, poznat kao crawling i indexing, ključan je za razumijevanje kako web stranice postaju vidljive na tražilicama i kako se može utjecati na njihovu poziciju u rezultatima pretrage.

Proces započinje crawlingom, odnosno skeniranjem. Google koristi posebne programe koji se zovu botovi ili Googlebot. Njihov zadatak je posjećivanje i učitavanje web stranica na internetu. Kada Googlebot dođe na određenu stranicu, on pregledava sav sadržaj, uključujući tekst, slike, poveznice i tehničke podatke. Ti botovi rade kontinuirano, a njihovo kretanje po internetu često se uspoređuje s načinom na koji pauci pletu mreže, pa se i sam proces naziva “web crawling”. Googlebot počinje s popisom poznatih URL-ova i slijedi poveznice koje pronalazi na tim stranicama, dodajući ih u svoj popis stranica koje treba posjetiti. Na taj način Google stalno otkriva nove web stranice i prati promjene na postojećima.

Jednom kada je stranica posjećena i skenirana, informacije se šalju Googleovim poslužiteljima gdje se analiziraju i pohranjuju u indeks. Indeksiranje je proces kategorizacije i razumijevanja sadržaja stranice. Google pokušava shvatiti o čemu je stranica, koji su ključni pojmovi, kakav je kontekst i koliko je stranica relevantna za određene upite korisnika. U tom procesu koriste se sofisticirani algoritmi koji obrađuju veliki broj faktora – od naslova i meta opisa do strukture sadržaja, kvalitete poveznica, brzine učitavanja stranice i prilagođenosti mobilnim uređajima. Ako stranica ispunjava tehničke uvjete i ako njezin sadržaj ima vrijednost za korisnike, Google će je dodati u svoj indeks, čineći je dostupnom u rezultatima pretrage.

Važno je naglasiti da crawling i indexing nisu isto što i rangiranje. Rangiranje se odnosi na poziciju stranice u rezultatima pretrage kada netko unese određeni upit. To znači da samo zato što je stranica indeksirana ne znači automatski da će biti visoko rangirana. Google koristi stotine signala i složene algoritme za određivanje redoslijeda prikaza rezultata, a ti algoritmi uzimaju u obzir faktore poput autoriteta stranice, relevantnosti sadržaja, brzine učitavanja, sigurnosti veze (HTTPS) i korisničkog iskustva.

Kako bi se osiguralo da stranica bude uspješno skenirana i indeksirana, vlasnici web stranica moraju voditi računa o određenim tehničkim aspektima. Na primjer, datoteka robots.txt služi za kontrolu ponašanja botova na web stranici. Pomoću nje se može odrediti koje stranice ili dijelovi stranice smiju, a koje ne smiju biti skenirane. Ako je stranica slučajno blokirana putem robots.txt ili meta oznaka “noindex”, Google je neće uključiti u svoj indeks. Osim toga, XML sitemap je koristan alat koji pomaže Googleu razumjeti strukturu web stranice i otkriti sve njezine važne stranice.

Brzina učitavanja stranice također igra ključnu ulogu. Ako se stranica učitava presporo, botovi mogu odustati od daljnjeg skeniranja ili posjetiti manji broj stranica nego što bi mogli da je stranica brža. Google također favorizira stranice koje su optimizirane za mobilne uređaje jer većina korisnika pretražuje internet putem mobilnih telefona. Stranice koje se ne prikazuju ispravno na mobitelima mogu imati problema s rangiranjem, čak i ako su indeksirane.

Osim tehničkih čimbenika, sadržaj stranice mora biti jedinstven, relevantan i koristan. Google posebnu pažnju posvećuje kvaliteti sadržaja jer mu je cilj korisnicima pružiti najbolje moguće odgovore na njihove upite. Stranice s dupliciranim sadržajem, slabim tekstom ili manipulativnim tehnikama (kao što su keyword stuffing) mogu biti indeksirane, ali rijetko postižu dobre pozicije. S druge strane, stranice koje redovito objavljuju originalan, dobro strukturiran i informativan sadržaj imaju veće šanse za bolje pozicioniranje.

Još jedan važan element procesa su poveznice. Unutarnje poveznice (linkovi između stranica unutar iste web stranice) pomažu Googleu razumjeti hijerarhiju i strukturu stranice, dok vanjske poveznice (backlinkovi) od drugih stranica ukazuju na autoritet i vjerodostojnost. Stranice koje imaju više kvalitetnih vanjskih poveznica često se smatraju pouzdanijima i imaju bolje šanse za visoko rangiranje. No, Google strogo kažnjava umjetno stvaranje poveznica ili korištenje manipulativnih taktika koje krše njegove smjernice.

Googleov proces skeniranja i indeksiranja je neprekidan i dinamičan. Internet se stalno mijenja – nove stranice nastaju, stare nestaju, a postojeće se ažuriraju. Kako bi zadržao ažurnost svog indeksa, Google stalno šalje botove da ponovno posjete već indeksirane stranice i provjere ima li novih informacija ili promjena. Stranice koje se često ažuriraju, kao što su portali s vijestima, blogovi i online trgovine, obično se češće posjećuju od onih koje se rijetko mijenjaju. Vlasnici web stranica to mogu iskoristiti redovitim objavljivanjem novog sadržaja kako bi potaknuli češće skeniranje.

Važnu ulogu u procesu igra i Google Search Console, alat koji omogućuje vlasnicima web stranica da prate kako Google vidi njihove stranice. Kroz njega se može zatražiti ručno indeksiranje određenih URL-ova, pregledati potencijalne pogreške u skeniranju, pratiti performanse stranica u rezultatima pretrage te dobiti preporuke za poboljšanje. Time se vlasnicima web stranica daje moćan alat za komunikaciju s Googleom i optimizaciju njihove prisutnosti na tražilici.

Važno je napomenuti da iako je tehnološki proces vrlo sofisticiran, Google nastoji zadržati osnovno načelo – pružiti korisnicima najrelevantnije i najkorisnije rezultate. Zbog toga su transparentnost, kvaliteta i korisničko iskustvo ključni faktori uspjeha. Pokušaji varanja algoritma obično kratkoročno mogu donijeti rezultate, ali dugoročno dovode do kazni i pada vidljivosti. Google kontinuirano unaprjeđuje svoje algoritme, uvodeći ažuriranja koja ciljaju na poboljšanje kvalitete rezultata, što znači da se vlasnici web stranica moraju stalno prilagođavati i ulagati u kvalitetan sadržaj i dobru tehničku optimizaciju.

U konačnici, proces skeniranja i indeksiranja web stranica od strane Googlea temelj je cijelog sustava pretraživanja. Razumijevanje tog procesa omogućuje vlasnicima web stranica, marketinškim stručnjacima i svima koji žele biti vidljivi na internetu da bolje planiraju svoje strategije i izbjegnu pogreške koje mogu dovesti do slabije vidljivosti. Iako ne postoji čarobna formula za trenutačno visoko pozicioniranje, jasno je da kombinacija tehničke ispravnosti, kvalitetnog sadržaja, brzine, mobilne optimizacije i prirodnog link buildinga daje najbolje dugoročne rezultate. Google svojom tehnologijom nastavlja oblikovati način na koji konzumiramo informacije, a razumijevanje njegova načina rada ključno je za uspjeh u digitalnom okruženju koje se stalno mijenja.

odabrano news portal koji nudi odabrane vijesti i informacije

odabrano news portal koji nudi odabrane vijesti i informacije